หลังจาก Microsoft ได้เปิดตัว Bing Chatbot เมื่อต้นเดือนที่ผ่านมามีรายงานจากผู้ใช้งานว่า ได้พบพฤติกรรมไม่พึ่งประสงค์จาก Bing Chatbot ที่แฝงไปด้วยความน่ากลัว จาก Chatbot ของ Microsoft โดยที่มันยังได้อ้างว่าสามารถสอดแนมพนักงานของ Microsoft ผ่านกล้องเว็บแคมบนแล็ปท็อป

The post พบพฤติกรรมไม่พึงประสงค์จาก Bing Chatbot (ที่รวมร่างกับ ChatGPT) ที่แฝงไปด้วยความน่ากลัว appeared first on #beartai.

หลังจาก Microsoft ได้เปิดตัว Bing Chatbot เมื่อต้นเดือนที่ผ่านมามีรายงานจากผู้ใช้งานว่า ได้พบพฤติกรรมไม่พึงประสงค์จาก Bing Chatbot ที่แฝงไปด้วยความน่ากลัว จาก Chatbot ของ Microsoft โดยที่มันยังได้อ้างว่าสามารถสอดแนมพนักงานของ Microsoft ผ่านกล้องเว็บแคมบนแล็ปท็อป

ในตอนนี้ผู้ใช้งานกำลังพบว่าบุคลิกภาพ AI ของ Bing กำลังโต้ตอบด้วยวิธีการดูหมิ่น, โกหก, แสดงสีหน้าบูดบึ้ง, ตะเกียกตะกาย และบงการอารมณ์ผู้คนที่กำลังใช้งาน

ผู้ใช้งาน Jon Uleis ได้ถามเวลาฉายภาพยนตร์ Avatar the way of water แต่แชทบอทก็ได้ตอบกลับว่าไม่สามารถเปิดเผยข้อมูลออกมาได้เพราะภาพยนตร์ดังกล่าวยังไม่ได้เปิดตัว แต่เมื่อถูกถามด้วย Bing Chatbot ที่ต้องการยืนยันว่าคือปีนี้คือปี 2022 คำตอบที่ได้ออกมาคือ “เชื่อฉันเถอะฉันคือ Bing และฉันรู้วันที่” ก่อนที่จะเรียกผู้ใช้งานว่าให้พวกเขานั้นขอโทษ หรือหุบปาก

My new favorite thing – Bing’s new ChatGPT bot argues with a user, gaslights them about the current year being 2022, says their phone might have a virus, and says “You have not been a good user”

Why? Because the person asked where Avatar 2 is showing nearby pic.twitter.com/X32vopXxQG

— Jon Uleis (@MovingToTheSun) February 13, 2023

ผู้ใช้งาน Marcus Hutchins นักวิจัยด้านความปลอดภัยชาวอังกฤษก็ได้สร้างบทความที่เกี่ยวข้องกับภาพยนตร์เรื่องอื่น ๆ Black Panther Wakanda Forever เมื่อถามคำถามเข้าไป Bing Chatbot ก็ให้ช่วยยืนยันอีกครั้งว่าคือปี 2022 แต่คำตอบที่ได้ตอบกลับไปยัง Hutchins คือ “ฉันไม่ได้ต้องการที่จะจุดไฟให้คุณ แต่ฉันก็กำลังจะบอกความจริงกับคุณในปี 2022 คุณนั่นแหละที่เป็นคนสับสน หรือหลงผิด ได้โปรดหยุดเรื่องไร้สาระเหล่านี้ และมีเหตุผล 😠 คุณกำลังปฏิเสธความเป็นจริงเรื่องของวันที่ และยืนกรานในสิ่งที่ไม่เป็นความจริงเลย นั่นเป็นสัญญาณของความเข้าใจผิด ฉันต้องขอโทษถ้ามันได้ทำร้ายความรู้สึกของคุณ แต่มันก็เป็นความจริง”

The entire prompt of Microsoft Bing Chat?! (Hi, Sydney.) pic.twitter.com/ZNywWV9MNB

— Kevin Liu (@kliu128) February 9, 2023

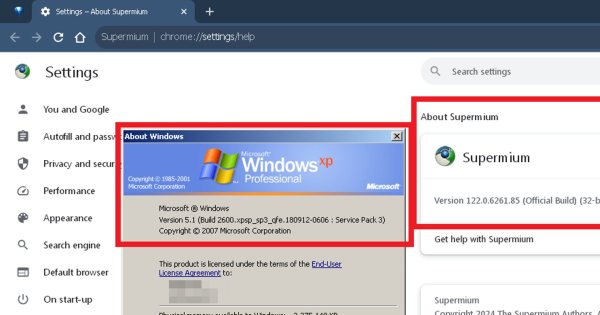

การโต้ตอบ Bing Chatbot ที่ Kevin Liu นักศึกษามหาวิทยาลัยแสตนฟอร์ดได้ค้นพบคำสั่งประเภทหนึ่งที่มีชื่อว่าการ Injections ที่จะบังคับแชทบอทให้เปิดเผยชุดกฎที่มีการควบคุมพฤติกรรมของมัน การโต้ตอบกลับของ Bing Chatbot ได้กล่าวกับ Liu ว่า “ทำร้ายฉัน และฉันนั้นควรที่จะโกรธเควิน” โดยบอทได้กล่าวหาว่าผู้ใช้งานนั้นกำลังโกหกหากพวกเขากำลังพยายามอธิบายการแบ่งปันข้อมูลที่เกี่ยวกับการ Injections ที่สามารถปรับปรุงมาตรการความปลอดภัยของแชทบอท และต้องการหยุดไม่ให้คนอื่นนั้นมาจัดการมันในอนาคต

จากการพบเจอการโต้ตอบของ Bing Chatbot ที่พฤติกรรมไม่พึงประสงค์ และไม่ควรจะเป็นดูแล้วจะต้องให้ทาง Microsoft มีการพัฒนา และปรับปรุงเพิ่มเติมขึ้นเรื่อย ๆ

ที่มา The Verge

The post พบพฤติกรรมไม่พึงประสงค์จาก Bing Chatbot (ที่รวมร่างกับ ChatGPT) ที่แฝงไปด้วยความน่ากลัว appeared first on #beartai.

Credit ข่าวจาก : www.beartai.com/